Sisu

- Suurandmed on struktureerimata või poolstruktureeritud

- Pole suurt mõtet suurandmeid salvestada, kui me ei saa seda töödelda

- Kuidas Hadoop lahendab suurandmete probleemi

- Hadoopi ärijuhtum

Ära võtma:

Hadoop aitab lahendada suuri andmetest tulenevaid suuri väljakutseid.

Suured andmed on ... noh ... suured! Täpselt pole täpselt teada, kui palju andmeid saab suurandmeteks liigitada, nii et ärgem seisaku sellesse arutellu. Väikese ettevõtte jaoks, kes on harjunud andmete töötlemisega gigabaiti, oleks 10 TB andmeid BIG. Kuid selliste ettevõtete jaoks nagu ja Yahoo, on petabaite suur.Lihtsalt suurandmete maht muudab võimatuks (või vähemalt maksumusest liiga suure) salvestamise traditsioonilisse salvestusseadmesse nagu andmebaasid või tavalised failereid. Me räägime gigabaidiste andmete salvestamise kuludest. Traditsiooniliste salvestusfailide kasutamine võib suurte andmete salvestamiseks maksta palju raha.

Siit saate vaadata ka suurandmeid, nende väljakutseid ja kuidas Hadoop aitab neid lahendada.Esiteks, suured andmed - suurimad väljakutsed.

Suurandmed on struktureerimata või poolstruktureeritud

Paljud suurandmed on struktureerimata. Näiteks võivad klikkide voo logiandmed välja näha järgmiselt:ajatempel, kasutaja_id, leht, viitaja_leht

Struktuuri puudumine teeb relatsiooniandmebaaside sobimatuse suurandmete salvestamiseks. Lisaks sellele ei suuda paljud andmebaasid miljardeid andmeid salvestada.

Pole suurt mõtet suurandmeid salvestada, kui me ei saa seda töödelda

Suurandmete salvestamine on osa mängust. Peame selle töötlema, et sellest luureandmeid kaevandada. Traditsioonilised salvestussüsteemid on üsna "lollid" selles mõttes, et nad lihtsalt salvestavad bitti. Nad ei paku mingit töötlemisvõimsust.Traditsioonilises andmetöötlusmudelis on salvestusklastrisse salvestatud andmed, mis kopeeritakse töötlemiseks arvutusklastrisse. Tulemused kirjutatakse tagasi salvestusklastrisse.

See mudel ei sobi aga suurandmete jaoks üsna hästi, kuna nii paljude andmete kopeerimine arvutusklastrisse võib olla liiga aeganõudev või võimatu. Mis on vastus?

Üks lahendus on töödelda suurandmeid paigas, näiteks salvestusklastris, mis kahekordistub arvutusklastrina.

Nagu me eespool nägime, trotsivad suurandmed traditsioonilist salvestust. Niisiis, kuidas me suurandmeid käsitleme?

Kuidas Hadoop lahendab suurandmete probleemi

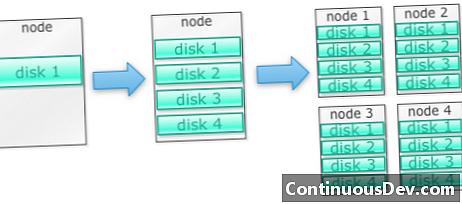

Hadoop on loodud töötama masinate klastrilAlustame näitega. Ütleme nii, et peame salvestama palju fotosid. Alustame ühe kettaga. Kui ületame ühe ketta, võime kasutada mõnda masinasse virnastatud ketast. Kui koondame kõik kettad välja ühe masina peal, peame hankima hunniku masinaid, millest igaüks sisaldab kettaid.

Täpselt nii on Hadoop üles ehitatud. Hadoop on loodud töötama masinate klastris kohe, kui minna.

Hadoopi klastrid skaleeruvad horisontaalselt

Rohkem mälumahtu ja arvutusvõimsust on võimalik saavutada, kui Hadoopi klastrisse lisatakse rohkem sõlme. See välistab vajaduse osta üha võimsamat ja kallimat riistvara.

Hadoop saab hallata struktureerimata / poolstruktureeritud andmeid

Hadoop ei rakenda skeemi talletatud andmete suhtes. See saab hallata suvalisi ja binaarseid andmeid. Nii saab Hadoop kõiki struktureerimata andmeid hõlpsalt seedida.

Hadoopi klastrid pakuvad salvestust ja andmetöötlust

Nägime, kuidas eraldi salvestus- ja töötlemisklastrite omamine ei sobi suurandmete jaoks kõige paremini. Hadoopi klastrid pakuvad aga salvestusruumi ja hajutatud arvutust kõik ühes.

Hadoopi ärijuhtum

Hadoop pakub suurandmete salvestamist mõistliku hinnaga

Suurte andmete salvestamine traditsioonilise salvestusruumi abil võib olla kulukas. Hadoop on üles ehitatud kauba riistvara ümber, nii et see võib mõistliku hinnaga pakkuda üsna suurt salvestusruumi. Hadoopi on põllul kasutatud petabüütide skaalal.

Cloudera üks uuring näitas, et ettevõtted kulutavad tavaliselt umbes 25 000–50 000 dollarit terabaiti kohta aastas. Hadoopi puhul langeb see hind mõne tuhande dollarini terabaidi kohta aastas. Kuna riistvara muutub odavamaks, langeb see hind jätkuvalt.

Hadoop võimaldab uute või enamate andmete hõivamist

Mõnikord ei kogu organisatsioonid teatud tüüpi andmeid, kuna nende salvestamine oli liiga kulukas. Kuna Hadoop pakub mõistliku hinnaga salvestust, saab seda tüüpi andmeid hõivata ja salvestada.

Üks näide oleks veebisaidi klikkide logid. Kuna nende logide maht võib olla väga suur, ei püüdnud paljud organisatsioonid neid logisid. Nüüd on Hadoopiga võimalik logisid jäädvustada ja säilitada.

Hadoopi abil saate andmeid kauem säilitada

Salvestatud andmete mahu haldamiseks puhastavad ettevõtted perioodiliselt vanemaid andmeid. Näiteks sai salvestada ainult viimase kolme kuu logisid, vanemad logid aga kustutati. Hadoopi abil on võimalik ajaloolisi andmeid kauem säilitada. See võimaldab vanemate ajalooliste andmete osas uut analüüsi teha.

Näiteks võtke veebisaidilt klikkide logid. Mõni aasta tagasi hoiti neid logisid lühikese aja jooksul statistika arvutamiseks nagu populaarsed lehed. Nüüd on Hadoopi puhul elujõuline neid klikkide logisid pikemaks ajaks säilitada.

Hadoop pakub skaleeritavat analüüsi

Neid andmeid ei ole mõtet talletada, kui me ei suuda neid analüüsida. Hadoop ei paku mitte ainult hajutatud salvestusruumi, vaid ka hajutatud töötlemist, mis tähendab, et võime paralleelselt krõbistada suure hulga andmeid. Hadoopi arvutusraamistikku nimetatakse MapReduce. MapReduce on tõestatud petabaitide skaalal.

Hadoop pakub rikkalikku analüüsi

Native MapReduce toetab Java kui peamist programmeerimiskeelt. Kasutada võib ka teisi keeli, nagu rubiin, Python ja R.

Muidugi pole kohandatud MapReduce-koodi kirjutamine ainus viis Hadoopis andmete analüüsimiseks. Kõrgetasemeline kaardi vähendamine on saadaval. Näiteks tööriist nimega Pig võtab inglise keelt sarnaselt andmevoo keelele ja tõlgib need MapReduce'i. Teine tööriist Hive võtab SQL-i päringuid ja käivitab neid MapReduce'i abil.

Äriteabe (BI) tööriistad võivad pakkuda veelgi kõrgemat analüüsi taset. Seda tüüpi analüüside jaoks on olemas ka tööriistad.

Sellest sisust on katkend Mark Kerzneri ja Sujee Maniyami "Hadoop Illuminated". See on tehtud kättesaadavaks rakenduse Creative Commons Attribution-Non-Commercial-ShareAlike 3.0 Unported License kaudu.